Coraz więcej firm wdraża rozwiązania AI oparte na modelach językowych (LLM), które potrafią analizować dane, generować treści i odpowiadać na pytania w języku naturalnym. Ich potencjał jest ogromny, jednak równie duże bywa ryzyko błędów. Gdy sztuczna inteligencja „halucynuje”, potrafi stworzyć pozornie poprawne, ale całkowicie wymyślone informacje.

W środowisku biznesowym, gdzie liczy się wiarygodność i zgodność z faktami, taki scenariusz jest nie do zaakceptowania. Dlatego coraz więcej organizacji szuka rozwiązań AI bez halucynacji, takich, które potrafią powiązać odpowiedź z rzeczywistymi dokumentami firmy.

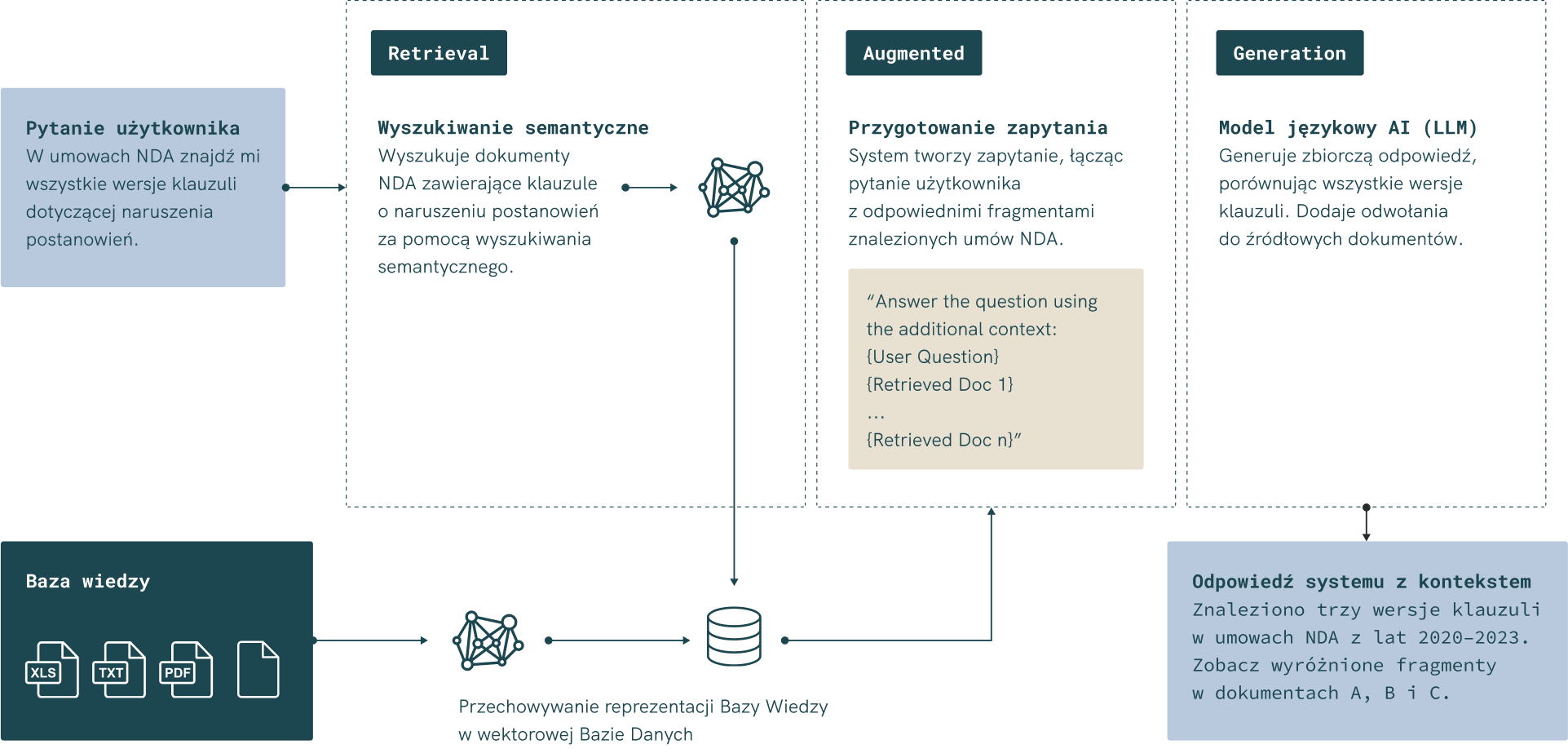

Tu pojawia się RAG (Retrieval-Augmented Generation) – architektura, która łączy moc sztucznej inteligencji z danymi organizacji, zapewniając kontrolę nad informacjami, pełną transparentność źródeł i bezpieczeństwo danych.

W połączeniu z lokalnym wdrożeniem AI lub prywatną chmurą organizacji, RAG pozwala tworzyć systemy konwersacyjne, które naprawdę rozumieją kontekst, a jednocześnie nigdy nie wychodzą poza granice firmowej infrastruktury.

TL;DR

- Halucynacje modeli językowych to błędne lub fikcyjne odpowiedzi generowane przez AI – szczególnie ryzykowne w środowisku biznesowym.

- RAG (Retrieval-Augmented Generation) to architektura, która łączy modele językowe z rzeczywistymi danymi organizacji, eliminując błędy i zwiększając wiarygodność.

- Dzięki RAG każda odpowiedź odwołuje się do źródła – np. pliku PDF, procedury, raportu lub e-maila – co zapewnia AI bez halucynacji.

- Lokalne wdrożenie AI (on-premise) lub prywatna chmura firmowa gwarantują, że dane nie opuszczają organizacji i pozostają pod pełną kontrolą.

- Model Context Protocol (MCP) umożliwia bezpieczną integrację AI z wewnętrznymi systemami – CRM, ERP, bazami dokumentów jako dodatkowymi źródłami dodającymi kontekstu firmowego.

- Recordya oferuje gotowe rozwiązanie oparte na RAG po polsku – bezpieczne, kontekstowe i gotowe do wdrożenia w każdej firmie. Skontaktuj się z nami i umów demo!

Czym właściwie są halucynacje w sztucznej inteligencji?

Wraz z rozwojem dużych modeli językowych (LLM), takich jak GPT-4, Gemini, Llama czy polski Bielik, sztuczna inteligencja potrafi generować teksty, streszczenia, analizy, a nawet kod. Modele te mają setki miliardów parametrów, co pozwala im odtwarzać ludzką komunikację w sposób zadziwiająco naturalny. Jednak mimo swojej mocy, nie są nieomylne.

Zjawisko znane jako halucynacje w sztucznej inteligencji polega na tym, że system generuje odpowiedzi, które brzmią wiarygodnie, ale są całkowicie nieprawdziwe lub oparte na błędnych założeniach. W praktyce może to oznaczać wymyślenie faktów, zniekształcenie treści z dokumentu lub podanie błędnego źródła.

Dlaczego tak się dzieje?

Każdy model uczy się na ogromnych zbiorach danych dostępnych w internecie. W momencie, gdy w pytaniu pojawia się temat, którego model nie zna lub zna niepełnie, „zgaduje” odpowiedź na podstawie wzorców językowych, zamiast na realnej wiedzy. I choć brzmi to przekonująco, w świecie organizacji i firm taka pomyłka może oznaczać poważne ryzyko – od błędnej interpretacji polityki po utratę kontroli nad informacjami.

Przykład?

Wyobraźmy sobie, że w firmie ktoś pyta asystenta AI o fragment umowy lub klauzulę RODO. Jeśli sztuczna inteligencja nie ma bezpośredniego dostępu do źródła, może „dopisać” brakujące zdanie. Brzmi dobrze, ale to już nie dokument – to fikcja.

Dlatego w środowisku biznesowym rozwiązania AI muszą działać inaczej: nie tylko generować treść, ale też opierać się na konkretnych, weryfikowalnych źródłach. I właśnie dzięki temu powstała architektura RAG, która łączy modele generatywne z prawdziwymi danymi firmowymi.

Dlaczego halucynacje to realny problem w zastosowaniach biznesowych

W zastosowaniach prywatnych błędna odpowiedź AI może być co najwyżej zabawna. W kontekście biznesowym — może kosztować firmy czas, pieniądze i reputację. Modele językowe stosowane w środowisku organizacyjnym muszą działać precyzyjnie, bo każda błędna informacja przekłada się na błędne decyzje.

1. Błędne dane = błędne decyzje

Gdy system AI generuje nieprawidłową analizę lub cytuje nieistniejący fragment dokumentu, powstaje ryzyko błędnych decyzji operacyjnych lub finansowych. Przykład: dział zakupów prosi o raport dotyczący aktualnych umów z dostawcami, a model „uzupełnia” brakujące dane, tworząc fałszywe wnioski.

2. Ryzyko naruszenia bezpieczeństwa danych

W tradycyjnych rozwiązaniach AI często wykorzystywane są zewnętrzne API lub modele open source, które przetwarzają dane poza infrastrukturą organizacji. To szczególnie niebezpieczne w firmach przetwarzających dane osobowe, poufne raporty lub wyniki badań. Użytkownik może nieświadomie przesłać wrażliwe informacje poza granice firmy – a tego nie da się cofnąć.

3. Utrata zaufania do sztucznej inteligencji

Jeśli pracownicy choć raz zauważą, że sztuczna inteligencja udziela błędnych odpowiedzi, przestają jej ufać. To z kolei niweczy wysiłki wdrożeniowe i powoduje, że zespoły wracają do manualnego wyszukiwania informacji w systemach. W rezultacie zamiast wsparcia, AI staje się przeszkodą.

4. Wpływ na zgodność i wizerunek

W środowiskach regulowanych, takich jak finanse, prawo czy zdrowie, każdy komunikat tworzony przez AI musi być możliwy do zweryfikowania. Gdy sztuczna inteligencja halucynuje, traci się możliwość udokumentowania źródła danych. Brak takiej ścieżki audytu może być niezgodny z regulacjami branżowymi i podważyć wiarygodność całej organizacji.

RAG – bezpieczniejsza droga do wdrożeń AI w organizacjach

Architektura RAG, czyli Retrieval-Augmented Generation, powstała po to, by połączyć elastyczność sztucznej inteligencji z wiarygodnością danych firmowych. Zamiast „zgadywać” odpowiedź, jak robią to klasyczne modele językowe, RAG najpierw sięga po informacje z określonych źródeł – np. dokumentów, baz danych, e-maili czy raportów – a dopiero potem generuje odpowiedź na ich podstawie.

Jak to działa w praktyce?

Proces RAG składa się z kilku etapów:

- Wyszukiwanie kontekstu (retrieval) – system przeszukuje zasoby organizacji, by znaleźć najbardziej trafne fragmenty danych.

- Łączenie z pytaniem (augmentation) – kontekst zostaje dodany do zapytania użytkownika, tworząc rozszerzony prompt.

- Generowanie odpowiedzi (generation) – model językowy formułuje odpowiedź, ale opiera ją wyłącznie na dostarczonych źródłach.

Dzięki temu każda odpowiedź AI ma realne uzasadnienie w treści, a użytkownik może zobaczyć, z jakich dokumentów pochodzi informacja. To nie tylko zwiększa zaufanie, ale też ułatwia kontrolę i audyt.

Dlaczego RAG eliminuje halucynacje?

W klasycznym podejściu AI generuje odpowiedzi z własnej pamięci statystycznej – im mniej zna kontekstu, tym większe ryzyko błędów. RAG działa odwrotnie:

- nie korzysta z „ogólnej wiedzy”,

- bazuje na danych firmowych lub dedykowanych repozytoriach tworząc interaktywną bazę wiedzy,

- podaje źródła każdej odpowiedzi,

- może działać w pełni lokalnie, w obrębie infrastruktury firmy.

Taka architektura pozwala wdrażać rozwiązania AI nawet w środowiskach o podwyższonych wymaganiach bezpieczeństwa – jak prawo, finanse czy badania R&D – bez ryzyka, że dane opuszczą organizację.

Jak RAG zwiększa wiarygodność i kontrolę nad sztuczną inteligencją

W świecie biznesu zaufanie do technologii to podstawa. Jeśli sztuczna inteligencja ma wspierać zespoły, jej odpowiedzi muszą być nie tylko szybkie, ale przede wszystkim – weryfikowalne. RAG pozwala to osiągnąć, zapewniając pełną kontrolę nad danymi i eliminując niepewność, z jaką często wiążą się tradycyjne modele językowe.

1. Odpowiedzi oparte na źródłach, nie na domysłach

Zamiast „zgadywać”, RAG tworzy odpowiedzi w oparciu o konkretne dokumenty i dane firmowe. Dzięki temu użytkownik może zobaczyć, skąd pochodzą użyte fragmenty treści – np. z regulaminu, raportu finansowego czy procedury HR. To oznacza, że AI nie tylko generuje wynik, ale też „uzasadnia”, skąd on się wziął.

Przykład:

Zamiast odpowiedzi typu „Tak, możesz wysłać dane klienta e-mailem”, RAG odwołuje się do wewnętrznego dokumentu i zwraca komunikat:

„Zgodnie z Polityką Przetwarzania Danych Osobowych (rozdz. 3.2) wysyłanie danych klientów e-mailem jest dozwolone wyłącznie w formie zaszyfrowanej.”

Taki poziom przejrzystości to rewolucja w wykorzystaniu sztucznej inteligencji do zarządzania wiedzą w organizacjach.

2. Transparentność i audytowalność

Każda odpowiedź generowana przez RAG może być przypisana do konkretnych źródeł danych. W praktyce oznacza to pełną ścieżkę audytu – od pytania użytkownika, przez przeszukane dokumenty, aż po końcową odpowiedź. W branżach regulowanych, gdzie liczy się zgodność z przepisami, to rozwiązanie bez precedensu.

3. Pełna kontrola nad danymi organizacji

W odróżnieniu od publicznych narzędzi AI, RAG nie wymaga wysyłania treści do zewnętrznych serwerów. System działa na danych firmowych, w obrębie własnej infrastruktury lub prywatnej chmury. Oznacza to, że dane osobowe, raporty finansowe czy wyniki badań nigdy nie opuszczają organizacji.

Dodatkowo systemy tego typu można rozbudować o zarządzanie dostępem wewnątrz firmy – przypisywanie poziomów uprawnień dla poszczególnych działów, ról lub użytkowników. Dzięki temu pracownicy widzą tylko te dokumenty i informacje, które są im rzeczywiście potrzebne w pracy. Takie podejście nie tylko wzmacnia bezpieczeństwo, ale też zapewnia zgodność z regulacjami branżowymi i zasadami minimalizacji dostępu do danych.

4. Większa wiarygodność = większa adopcja

Gdy pracownicy mogą ufać, że odpowiedzi AI są poparte realnymi źródłami, zaczynają z niej aktywnie korzystać. To zwiększa efektywność zespołów, skraca czas wyszukiwania informacji i odciąża działy wsparcia. Dzięki temu RAG nie tylko rozwiązuje problem halucynacji, ale też przyspiesza adaptację rozwiązań AI w firmie.

Model Context Protocol – nowy sposób rozszerzania wiedzy i kontekstu dla RAG

Nawet najlepiej zaprojektowany system RAG działa w ramach tego, do czego ma dostęp. Co jednak w sytuacji, gdy sztuczna inteligencja potrzebuje informacji spoza indeksowanej bazy dokumentów — np. z CRM, systemu zgłoszeń serwisowych, bazy klientów czy repozytorium kodu?

Tu z pomocą przychodzi Model Context Protocol (MCP) – nowy standard komunikacji między modelami językowymi a firmowymi systemami danych.

Jak działa Model Context Protocol

Zamiast przesyłać treści do chmury, MCP pozwala modelom w sposób kontrolowany i bezpieczny „dopytywać” organizacyjne systemy o dodatkowy kontekst – zawsze w ramach zdefiniowanych reguł dostępu.

Dzięki temu:

- LLM może w czasie rzeczywistym pobierać dane z wewnętrznych źródeł – np. wynik zapytania SQL, status projektu w Jirze czy treść umowy w systemie DMS,

- rozwiązania AI działają w pełni w infrastrukturze organizacji,

- dane pozostają prywatne, a każda interakcja z systemami jest możliwa do audytu.

Dlaczego MCP i RAG to silne połączenie

Połączenie RAG i Model Context Protocol sprawia, że AI przestaje być „statycznym” asystentem, który odpowiada tylko z wcześniej zaindeksowanej bazy wiedzy.

System może teraz:

- rozszerzać kontekst o dane operacyjne i wyniki w czasie rzeczywistym,

- generować bardziej precyzyjne odpowiedzi,

- reagować na aktualne informacje z firmowych systemów bez ryzyka ujawnienia danych poza infrastrukturę.

Lokalne i prywatne wdrożenia AI – bezpieczeństwo danych i efektywność w praktyce

Nie każda organizacja może sobie pozwolić na korzystanie z publicznych modeli językowych dostępnych w chmurze. Często to kwestia regulacji branżowych (np. branże legal, healthcare czy pharma), ochrony danych osobowych lub po prostu dbałości o poufność informacji biznesowych. Dlatego coraz więcej firm decyduje się na lokalne wdrożenie AI lub prywatną infrastrukturę chmurową, które pozwalają zachować pełną kontrolę nad tym, gdzie i w jaki sposób przetwarzane są dane.

Lokalne wdrożenie (on-premise)

W tym modelu systemy AI – w tym RAG i Model Context Protocol – działają w całości w środowisku organizacji. Serwery, baza dokumentów i modele językowe są uruchamiane lokalnie, dzięki czemu żadne dane nie opuszczają infrastruktury firmy.

To rozwiązanie idealne dla organizacji, które:

- przetwarzają dane osobowe lub informacje wrażliwe,

- działają w branżach o wysokich wymaganiach compliance (finanse, prawo, R&D),

- chcą mieć pełną kontrolę nad danymi i przepływem informacji,

- budują przewagę dzięki bezpieczeństwu i niezależności od dostawców zewnętrznych.

.png)

Prywatna chmura organizacji

W wielu przypadkach bardziej elastycznym rozwiązaniem jest prywatna chmura – środowisko oparte o zasoby chmurowe, ale zarządzane i zabezpieczone przez samą organizację.

W tym scenariuszu:

- AI działa w odizolowanym, szyfrowanym środowisku,

- dane nie są wykorzystywane do treningu publicznych modeli językowych,

- możliwe jest skalowanie obliczeń przy zachowaniu niskich kosztów.

Dlaczego warto rozważyć prywatne lub lokalne wdrożenie

Połączenie lokalnych zasobów z architekturą RAG i protokołem MCP pozwala firmom nie tylko zwiększyć bezpieczeństwo, ale też zoptymalizować koszty infrastruktury:

- ograniczenie wydatków na zewnętrzne API,

- brak opłat za transfer danych,

- możliwość wykorzystania istniejącego sprzętu lub prywatnych klastrów GPU,

- szybkie odpowiedzi w czasie rzeczywistym, bez zależności od internetu.

Podsumowanie – jak wdrożyć sztuczną inteligencję bez halucynacji

Coraz więcej firm odkrywa, że prawdziwa przewaga nie polega już tylko na wdrażaniu sztucznej inteligencji, ale na tym, jak z niej korzystać. Klasyczne modele językowe potrafią generować imponujące treści, lecz bez kontekstu i nadzoru mogą wprowadzać błędy lub ujawniać poufne dane.

Dlatego rozwiązania oparte na architekturze RAG i rozszerzone o Model Context Protocol stają się fundamentem bezpiecznych wdrożeń. Dzięki temu firmy mogą w pełni wykorzystać sztuczną inteligencję, nie rezygnując z bezpieczeństwa ani kontroli.

Dlaczego warto postawić na nowoczesne rozwiązania AI?

- Wiarygodność i transparentność – każda odpowiedź ma źródło, które można zweryfikować.

- Bezpieczeństwo danych osobowych – system działa w obrębie infrastruktury organizacji, bez wysyłania informacji do publicznych serwerów.

- Integracja z systemami firmowymi – modele komunikują się z bazami, CRM czy DMS poprzez prywatne API.

- Elastyczność wdrożeń – rozwiązania można uruchomić zarówno jako lokalne systemy on-premise, jak i w prywatnej chmurze organizacji.

- Wsparcie w pracy zespołów biznesowych – AI działa jak asystent, który odpowiada w czasie rzeczywistym, przeszukując tysiące dokumentów i pomagając w podejmowaniu decyzji.

W praktyce oznacza to, że sztuczna inteligencja przestaje być ryzykownym eksperymentem, a staje się narzędziem, które realnie wspiera strategię organizacji. Dzięki RAG i MCP możesz mieć pewność, że Twoja firma korzysta z najnowszych technologii w sposób odpowiedzialny, ekonomiczny i zgodny z regulacjami.

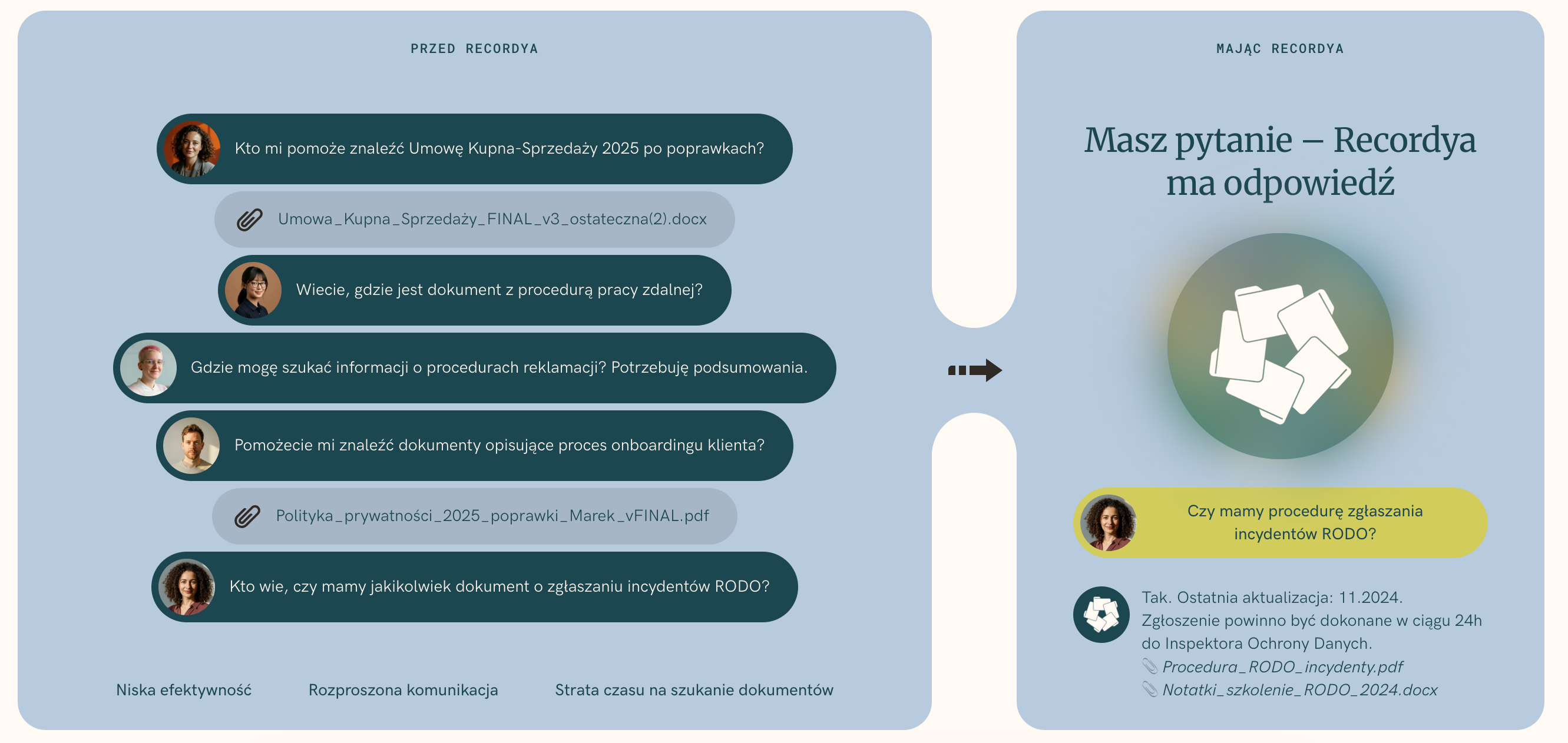

Recordya to gotowe, sprawdzone rozwiązanie oparte na RAG – bezpieczne, lokalne i w pełni dostosowane do potrzeb polskich organizacji.

System łączy modele językowe LLM, przetwarzanie języka naturalnego i integrację z firmowymi systemami, tworząc inteligentne centrum wiedzy dla całej organizacji.

Umów demo Recordya, by zobaczyć, jak możesz wdrożyć AI bez halucynacji w swojej firmie – szybko, bezpiecznie i z pełną kontrolą nad danymi.